2.1.3.4.2.De l’utilité déterministe à l’utilité aléatoire

La présentation précédente de la théorie de l’utilité met en évidence les limites de ce cadre d’analyse, du fait que les hypothèses sur lesquelles il se fonde sont réductrices par rapport à la réalité. En effet, l’individu et son système de choix sont caractérisés par :

- Une possible captivité à un mode, du fait, par exemple, de revenus faibles, qui implique que le choix n’est pas toujours réel. L’observation des comportements individuels fait en effet ressortir que les schémas d’activité des individus sont marqués par un certain nombre de régularités qui montrent que l’individu dispose de marges de manœuvre limitées, qui définissent son univers de choix. Celui-ci est la résultante non seulement des contraintes qui pèsent sur lui, mais également des ressources (temps, argent, mode de locomotion…) dont il bénéficie (Raux et alii, 1995).

- Une possible sous-information concernant l’alternative utilisée, et une non-information concernant les alternatives non utilisées : les pratiques modales s’ancrent dans des habitudes modales et spatiales, et entraînent une certaine inertie (Kaufmann, 2000) ce qui remet en cause le fait que le choix soit conscient.

- La multiplicité des processus de décision, qui implique que les choix ne sont pas toujours cohérents.

- L’existence de seuil, d’où une discontinuité de la réponse au changement et la non-compensation entre les caractéristiques des alternatives (l’augmentation du prix du ticket n’est pas forcément compensé par des gains de temps du fait de l’introduction d’un mode plus rapide), phénomènes qui impliquent que les individus ne réagissent pas de manière continue au changement.

- La dépendance des choix entre individus à l’intérieur d’un même groupe social et entre groupes sociaux, qui implique que le choix est limité.

L’hypothèse de rationalité des individus qui est le fondement de la théorie micro-économique du consommateur représente donc une limite forte dans la réalité pour l’analyse des comportements, dans la mesure où deux individus placés dans la même situation peuvent très bien faire des choix différents. Comme le souligne P. Bonnel (2002), ce n’est pas que les individus ne soient pas rationnels, mais leur rationalité n’est pas forcément celle de l’homo oeconomicus telle que l’on est conduit à la définir pour la modélisation.

En outre, la théorie du consommateur s’applique à l’étude de la demande d’un bien dont les quantités varieraient continûment. Or cette hypothèse est incompatible avec l’étude du bien « transport public urbain »qui possède les caractéristiques suivantes :

- les services sont immatériels, intangibles : même si cette immatérialité est plus ou moins forte selon les services, elle a pour conséquence la difficulté pour le client d’évaluer à l’avance le service, difficulté accrue par le fait que les services sont hétérogènes d’une prestation à l’autre : l’offre et la qualité diffèrent dans le temps et l’espace (Faivre d’Arcier et al., 1993).

- comme le souligne Goodwin (1984), la mise en service d’une nouvelle infrastructure s’accompagne généralement d’une montée en charge progressive pouvant même s’étaler sur une durée très longue. Les changements sont souvent le fait de changements dans le cycle de vie.

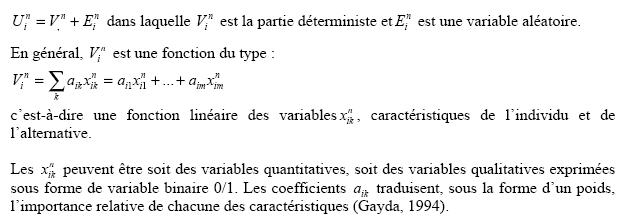

Ces raisons font qu’il est nécessaire de trouver une méthode intégrant la diversité des préférences individuelles qui induisent la variabilité des choix faits. L’idée est donc d’associer à un élément déterministe fonction des caractéristiques observables de l’individu n et de l’alternative i une variable aléatoire, de valeur inconnue, qui reflète les goûts (non mesurés) particuliers à chaque personne, ainsi que les erreurs de mesure ou d’observation, faites sur les caractéristiques explicitement prises en compte dans la partie déterministe (nous détaillerons la composition du terme aléatoire plus bas). D’après Ben-Akiva et Lerman (1997), c’est Manski 45 qui est le premier à avoir formalisé cette approche. Ainsi, la fonction d’utilité est la somme de deux composantes :

La variable aléatoire est souvent appelée terme d’erreurs. On peut classer ces erreurs de la manière suivante (Bonnel, 2002) :

- Erreurs relatives à la construction théorique : nous faisons un choix pour les variables que nous introduisons dans la fonction d’utilité, car il n’est pas possible, ne serait-ce que pour des raisons d’estimation, de prendre en compte l’ensemble des variables pouvant avoir un rôle dans le processus de choix des individus.

- Erreurs relatives à la spécification des relations : en général, la forme retenue pour la fonction d’utilité est additive ; or, il n’est pas sûr que la contribution effective des variables soit toujours additive. La seconde dimension est liée à la forme de la fonction de distribution pour les résidus et aux hypothèses que l’on fait concernant ces résidus.

- Erreurs relatives à la production de données : à certaines erreurs mesurables, telle que l’erreur d’échantillonnage, il faut en rajouter d’autres : base de sondage incomplète, refus de réponse, individus non contactés, questions mal comprises, qualité insuffisante du questionnaire, biais liés à l’enquêteur et à l’enquêté…

- Erreurs de calage : comme nous le verrons plus bas, l’estimation des coefficients inconnus s’effectue à l’aide de procédures statistiques nécessitant que certaines hypothèses soient respectées, ce qui peut ne pas être le cas.

(Pour une présentation détaillée des apports successifs faits à la théorie de l’utilité aléatoire, voir Mc Fadden, 2001, pp. 21-22)

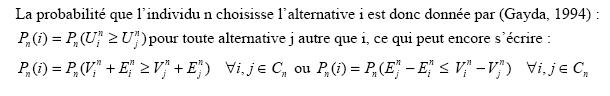

La présence du terme aléatoire dans la définition de la fonction d’utilité implique que le calcul de l’utilité renvoie à des modèles probabilistes qui prévoient la probabilité que les individus fassent un certain choix, mais pas directement le choix lui-même. La présence de ce terme aléatoire permet de tenir compte des éventualités suivantes (Ortuzar, Willumsen, 1994) :

- deux individus ayant les mêmes attributs socio-économiques, et confrontés au même ensemble de choix, peuvent choisir deux options différentes ;

- certains individus peuvent ne pas choisir l’alternative la meilleure du point de vue des attributs considérés dans la modélisation.

Cette présentation de la fonction d’utilité implique toutefois que l’on fait en amont plusieurs hypothèses relatives au comportement des individus devant opérer un choix entre plusieurs alternatives (Dussaix, 1992) :

- l’individu perçoit un produit ou un service comme un ensemble d’attributs ou de caractéristiques.

- Lorsqu’il évalue le produit, l’individu associe des valeurs subjectives à chaque modalité des caractéristiques : ces valeurs sont appelées utilités partielles et reflètent son système de valeurs.

- Pour déterminer l’utilité d’un produit, l’individu fait la somme des utilités partielles des caractéristiques qui le constituent. Il s’agit donc d’un modèle additif.

- L’individu choisit parmi les produits celui qui lui procure l’utilité totale la plus élevée.

Nous verrons dans le paragraphe 1.1.4 que ces hypothèses sur la structuration des préférences des individus, qui sont celles d’un processus compensatoire entre attributs, sont fortes et limitent l’exercice.

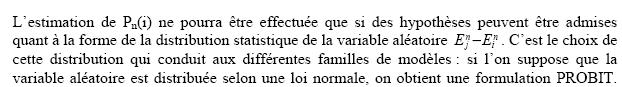

Toutefois, ce modèle, fondé sous des hypothèses assez simples, présente l’inconvénient d’être très difficile à estimer dès que le nombre d’alternatives est supérieur à 3, ce qui explique sa faible utilisation dans les logiciels. Pour faire face à cette difficulté d’estimation, des hypothèses restrictives ont été posées quant à la distribution des termes aléatoires, et notamment une distribution identique et indépendante pour chacune des alternatives. Parmi ces distributions, la distribution de Gumbel est la plus couramment utilisée car elle conduit à un modèle très simple, même face à des univers de choix multidimensionnels : le modèle LOGIT multinomial (MNL est la terminologie anglo-saxonne). Toutefois, sa simplicité, qui découle de ses hypothèses, entraîne la propriété d’indépendance des alternatives (IIA selon les initiales anglo-saxonnes). Or cette propriété est souvent violée lorsque le nombre d’alternatives augmente, ce qui a poussé à proposer dans un premier temps des modèles de choix hiérarchiques permettant de lever les hypothèses les plus contraignantes. Mais la solution reste partielle dans le sens où une partie seulement de ces hypothèses est levée, c’est pourquoi la nouvelle génération de modèles vise à traiter simultanément toutes les hypothèses. Nous détaillons tous ces éléments dans le paragraphe qui suit.