Un ouvrage de référence dû à des « simulateurs » en recherche opérationnelle

Enfin, la référence qui est faite ici à la fin du passage sus-cité est très significative. Il faut en dire quelques mots. Remarquons d’abord que ce sont bien les physiciens de la faculté d’Abidjan (Marchand et Lapasset), que de Reffye rencontrait souvent, ceux mêmes qui l’avaient conseillé dans l’achat de matériel, qui l’ont également initié à la simulation par ordinateur. Ce sont eux qui l’ont incité à travailler à partir du livre de Naylor et Balintfy 1574 . Les recherches de de Reffye ont pu ainsi bénéficier de conseils prodigués par des physiciens eux aussi relativement exilés des centres de recherches majeurs en leur domaine.

L’ouvrage Computer Simulation Techniques esten effet un des premiers manuels assez complets de techniques de simulation mais dont les auteurs ont une origine principalement dans l’économie, la technométrie 1575 , le management ou la recherche opérationnelle. Lors de la parution de cet ouvrage fondateur, Thomas H. Naylor est professeur associé d’économie à l’université de Duke et Joseph L. Balintfy est professeur associé de recherche opérationnelle à l’université de Tulane. Les deux autres co-auteurs ne sont pas non plus des chercheurs dans les sciences de la nature : Donald S. Burdiock est assistant de mathématique à l’université de Duke et Kong Chu est professeur associé de management industriel à Georgia-Tech (Georgia Institute of Technology). Certes, cet ouvrage n’est pas le premier sur le sujet 1576 . Mais il présente un panorama complet des techniques élémentaires de simulation numérique sur ordinateur (appelé digital computer par les auteurs). De plus, dans un premier chapitre, il exprime pour la première fois une réelle réflexion sur les différents usages épistémologiques de la simulation numérique : en exposant différentes nuances, les auteurs en trouvent 15 en tout.

Mais l’une des nouveautés majeures de cet ouvrage est qu’il présente la simulation numérique comme une nouvelle pratique scientifique à part entière, à côté des méthodes analytiques ou spéculatives traditionnelles, et qu’il développe ainsi quelques arguments d’ordre épistémologique. Pour ce faire, les auteurs ont d’abord recours à une philosophie des sciences positiviste, assez répandue à cette époque dans les pays anglo-saxons, celle de Hans Reichenbach. Selon cette épistémologie, le travail scientifique procèderait en quatre étapes : l’observation, la formulation d’hypothèses explicatives et prédictives sous la forme de modèles mathématiques, le traitement de ces modèles (résolutions logiques, calculs…) pour en obtenir des prédictions, enfin la constitution d’expérimentations pour tester la validité des modèles 1577 . Les auteurs se demandent donc à quel niveau la simulation numérique peut bien apporter son soutien. Leur réponse est surprenante : à tous les niveaux, affirment-ils. Ainsi, et en substance, la simulation servirait notamment à pallier le défaut de données lorsqu’elles sont inaccessibles, que ce soient les données servant, en amont du travail scientifique, à l’induction 1578 , c’est-à-dire dans le processus de création d’une hypothèse théorique ou que ce soient les données servant, en aval, à la vérification de cette hypothèse théorique et de ses prédictions. Elle servirait également à pallier le défaut d’une expression mathématique du modèle par équations classiques ou bien encore l’absence d’une résolution mathématique analytique du modèle mathématique obtenu, quand bien même il serait formulable par des équations générales classiques 1579 . Ainsi, pour les auteurs de cet ouvrage, dès lors que la simulation numérique peut jouer un rôle à chaque étape du travail scientifique, il est incontestable qu’elle peut entre autres servir à « vérifier des solutions analytiques » 1580 , c’est-à-dire se substituer en quelque sorte à la quatrième étape du travail scientifique, celle de la vérification empirique.

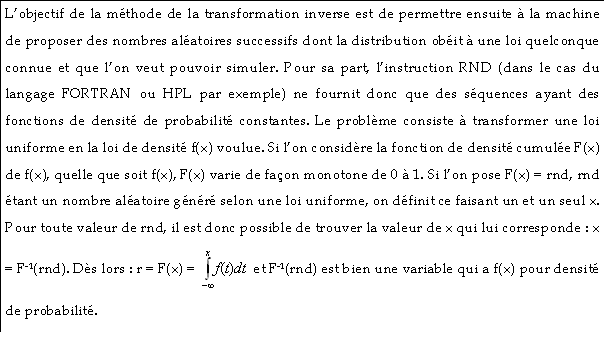

| Afin de simuler le tirage au sort d’événements successifs obéissant à une loi de probabilité donnée, il fallait d’abord disposer de nombres aléatoires. Or, il existe quatre sources possibles de nombres aléatoires : 1- les méthodes manuelles (lancers de pièces, de dés, roulettes…) ; 2- les tables numériques publiées de séquences aléatoires comme celle de la RAND Corporation 1582 , ces tables ayant été auparavant établies par un travail mettant en œuvre une des trois autres méthodes ; 3- les méthodes des calculateurs analogiques (fondées sur des processus physiques aléatoires comme le comportement d’un courant électrique) ; 4-les méthodes des calculateurs numériques. Les méthodes 1 et 3 peuvent donner l’impression de fournir des nombres aléatoires « vrais » mais elles présentent l’énorme inconvénient d’interdire la reproduction de la séquence aléatoire, ce qui est nécessaire pour la vérification des calculs, l’emploi de tests statistiques a posteriori, etc. La méthode 2 est très lente et ne peut pas être implémentée dans un calculateur numérique sans que lui soit communiqué ce gros désavantage puisqu’il faut stocker la séquence intégralement dans une mémoire (à cartes ou sur bandes magnétiques à l’époque, donc à accès très lents). Au milieu des années 1950, sous l’impulsion des premiers travaux de von Neumann en ce sens, puis de ceux d’un mathématicien de Berkeley, Derrick H. Lehmer, les méthodes purement numériques de génération (par récurrence) sont donc privilégiées. Ainsi, au début des années 1960, presque tous les calculateurs numériques disposent, dans leur code, d’une instruction (souvent RANDOM ou RND) qui leur permet d’extraire des nombres aléatoires par telle ou telle « variante des méthodes congruentielles de Lehmer » 1583 . Le plus souvent, cette instruction met à disposition une loi de probabilité uniforme sur un intervalle quelconque de nombres entiers. C’est-à-dire que, du point de vue des tests statistiques, chaque nombre y est proposé avec une même probabilité. |

Dans l’article de 1977 publié par les quatre chercheurs de l’IFCC, la méthode de génération de nombres pseudo-aléatoires (voir encadré) est textuellement reprise de l’ouvrage de Balintfy et Naylor. De manière très frappante, les notations elles-mêmes sont conservées. Comme il le fit dans le premier article de 1976, de Reffye propose ensuite un organigramme témoignant du traitement successif et imbriqué des modèles. Mais à la différence des deux programmes de 1976, celui-ci présente une simulation nettement aléatoire puisque c’est l’approche par la reconstitution des événements successifs dans leur caractère aléatoire même (et non dans une fonction temporelle certaine d’apparition) qui est choisie. Les auteurs résument eux-mêmes la séquence de l’organigramme :

‘« Dans un premier temps, on propose à l’aide de la loi des passages efficaces des nombres représentant les dépôts des paquets de grains de pollen suivant leurs fréquences naturelles.’ ‘Dans un deuxième temps, ces nombres sont introduits dans une boucle où l’on choisit les amas de grains de pollen suivant leur distribution naturelle de fréquence. Lorsque la boucle est terminée, on a la somme totale des grains de pollen apportés sur le style. » 1584 ’Après le tirage d’un premier nombre aléatoire, la première étape de programme détermine donc aléatoirement le nombre total de passages efficaces qui vont affecter le style. Ensuite le programme entre dans une boucle : pour chacun de ces passages efficaces, le programme détermine aléatoirement (donc après tirage d’un deuxième nombre aléatoire) le nombre de grains qu’il y a dans l’amas apporté par ce passage efficace. À la fin de la boucle, le programme somme tous les grains apportés par tous les passages efficaces et donne le résultat.