II.2.B L’agent et les Systèmes Multi-Agents

L’agent

Le concept d’agent est né dans le cognitivisme et se développe aussi bien en Intelligence Artificielle qu’en Psychologie. Le cognitivisme présuppose que la rationalité humaine est indépendante de l’affectif ou des émotions au point de penser à la conception d’un « agent rationnel ».

Selon Newell (1982), la rationalité est un principe central et considère un agent comme un système abstrait décrit en termes de buts, d’actions et de connaissances. Ces buts, actions et connaissances sont régit par un principe : la rationalité. La machine de calcul est le support privilégié pour la conception des agents parce qu’elle n’est que rationalité incorporée dans la matière à travers des mécanismes qui réalisent des théorèmes logico-arithmétiques. Le principe de la téléologie est aussi important dans cette approche car l’agent est contraint à se servir de ses connaissances pour déterminer quelles actions entreprendre pour atteindre ses objectifs. La stratégie de résolution de problèmes de ces agents cognitivistes est la décomposition. Rationnellement, un agent choisit, dans un ensemble d’actions possibles, quel sous-ensemble d’actions est le meilleur pour la résolution de la première partie du problème. L’agent a, au préalable, soigneusement découpé le problème en parties qu’il pourra résoudre tour à tour avec des sous-ensembles d’actions correctes.

L’approche cognitiviste a mis en évidence la matérialité de l’intelligence comme jamais auparavant, néanmoins le principe de la rationalité en logique s’applique mal à la rationalité humaine. Les études sur les fautes dans les raisonnements humains, fautes en simples déductions logiques chez l’Homme montrent qu’il n’est pas un prouver de théorèmes, loin de là (Johnson-Laird & Wason, 1970). Le système conatif, où se trouvent les affects, désirs, émotions, etc., se présente comme un système d’une autre « rationalité ». L’homme s’appui sur son environnement social et physique pour résoudre ses problèmes (Gibson, 1979).

Ferber (1995) appelle « agent » une entité informatique dont le processus est situé dans un environnement qui peut être réel ou virtuel. Ce processus autonome se trouve en interaction avec d’autres agents, formant ainsi une structure sociale qui est à la base de leur organisation sociale.

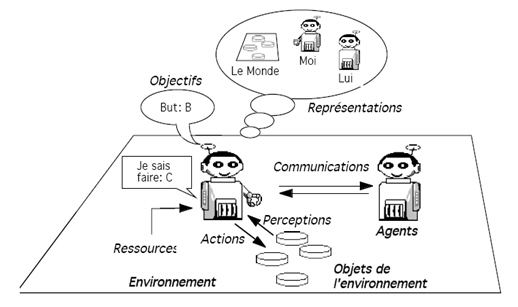

Dans un univers multi-agents, l’agent agit sur son environnement, il perçoit des objets et d’autres agents et peut avoir des représentations de son environnement, des autres agents et de lui-même. La manipulation de ces représentations symboliques se fait à travers de ce que l’agent sait faire, i.e. sa routine définie de façon algorithmique. Grâce à ses capacités intrinsèques, l’agent peut communiquer directement ou indirectement avec d’autres agents et il a des tendances internes telles que des buts ou des niveaux de satisfaction.

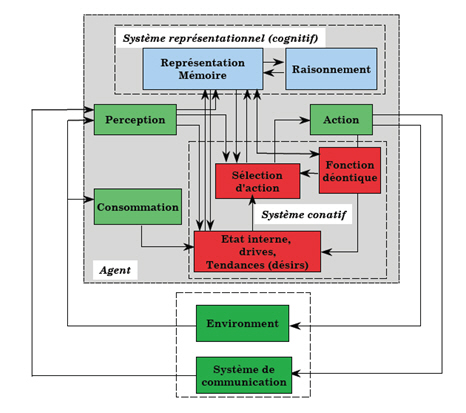

Ferber (2006) présente quatre fonctions spécifiques de l’architecture générale d’un agent.

| Fonctions spécifiques de l'agent | Descriptif |

| Fonction représentationnelle (ou cognitiviste) | Les représentations ici sont vues comme des symboles matériels. Plus développée chez les agents cognitivistes, ils ont des représentations internes de leur environnement qu'ils manipulent afin de planifier ses actions. |

| Fonction conative (ou fonction de contrôle) | Cette fonction est décomposée en trois autres : La fonction motivationnelle pose les buts ou tendances. Il y a des tendances internes (besoins, désirs, pulsions) et externes (demandes des autres agents, pressions sociales). La fonction déontique pose les contraintes normatives de l'organisation et gère la façon que les lois de l'organisation vont venir structurer l'ensemble d'actions possibles de l'agent. La fonction sélection d'action sert à prendre la décision selon l'état de l'agent. |

| Fonction interactionnelle | Il s'agit des fonctions d'entrée-sortie et interface. Les fonctions de perception et d'actions sont ici définies. |

| Fonction végétative | Très importantes chez les robots, la fonction végétative prévoit que l'agent doit se réalimenter afin de pouvoir continuer son travail. Les capacités de reproduction de l'agent sont ici prévues. |

Une architecture typique d’agent basée sur ces fonctions spécifiques est proposée par Ferber (2006).

La recherche de l’autonomie chez les agents a été définie par Ferber (2006) comme une

‘« capacité à exécuter une action de sa propre initiative (pro-activité), en contrôlant son comportement afin d’atteindre une plus grande satisfaction et en décidant d’aider ou d’empêcher les autres de satisfaire leurs buts » (p. 26)’Malgré cette autonomie, l’intentionnalité chez les agents

‘« consiste à interpréter tous les comportements d’un agent en les considérant mûs par des intentions (par exemple) : il a été chercher de la nourriture parce qu’il avait faim. Il a poussé l’autre agent parce qu’il voulait prendre sa place, etc.), même si l’architecture effective de l’agent ne manipule effectivement aucune intention. » (Ferber, 2006, p. 31)’Pour Brentano (1874) l’intentionnalité permet de distinguer un système mental d’un système physique. En tant que système physique symbolique de l’IA classique, l’agent est une entité informatique sans une vie mentale effective. Néanmoins, il est un moyen de modélisation du mental.

L’intentionnalité s’éloigne de la notion d’ « acte mental conscient » pour venir vers ce qui émerge dans un monde régi par les lois physiques et chimiques comme un système qui n’est plus réactif à ces lois. Un système cognitif met en place ses lois locales et au travers d’elles il peut agir de sa propre initiative.

L’agent n’est pas vraiment composé d’une rationalité, tel que chez les humains, ni d’une capacité cognitive plus simple mais plus efficace, néanmoins nous pouvons souvent le décrire en utilisant un vocabulaire typique des systèmes intentionnels.

‘« Here is how it works: first you decide to treat the object whose behavior is to be predicted as a rational agent; then you figure out what beliefs that agent ought to have, given its place in the world and its purpose. Then you figure out what desires it ought to have, on the same considerations, and finally you predict that this rational agent will act to further its goals in the light of its beliefs. A little practical reasoning from the chosen set of beliefs and desires will in most instances yield a decision about what the agent ought to do; that is what you predict the agent will do. » 7 (Dennett, 1987, p. 17)’La psychologie populaire, à un niveau naïf induit par le langage, croit à une véritable intention humaine. « L’Homme décide des ses actions à la lumière de ses idées », selon les croyances populaires (Dennett, 1987). Par la compréhension des mécanismes intentionnels, nous pouvons concevoir des agents cognitivistes. Naïvement, les comportements de l’agent peuvent être justifiés par une attitude intentionnelle. L’agent fait ceci car il « désire » cela, ou car il « croit » à ceci. De telles descriptions sont préférables à une description au niveau physique, « physical stance », ou de conception, « design stance » (Dennett, 1987), (Engel, 1995).