3. Modèles de lecture « en triangle »

3.1. Modèle à Traitement Parallèle Distribué

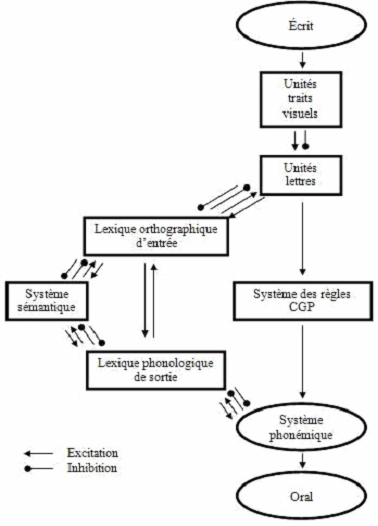

Le modèle à Traitement Parallèle Distribué (i.e., Parallel Distributed Processing, PDP, Seidenberg & McClelland, 1989) ainsi que son extension (Plaut, McClelland, Seidenberg & Patterson, 1996) sont des modèles connexionnistes, successeurs du modèle princeps à Activation Interactive (i.e., Interactive Activation Model, IAM, McClelland & Rumelhart, 1981) dont les architectures sont inspirées de l’organisation triangulaire séparée des unités orthographiques, phonologiques et lexicales, interconnectées par des connexions activatrices et inhibitrices bidirectionnelles. À la différence du modèle de McClelland & Rumelhart (1981), les représentations sont distribuées et non localisées.

Dans ce type de modèle (Figure 6), l’apprentissage est progressif et permet de modifier les connexions automatiquement entre chacun des niveaux, jusqu’à ce que l’information d’entrée soit en adéquation avec l’information de sortie, car le réseau n’a aucune connaissance préalable. La reconnaissance visuelle d’un mot (anglais et monosyllabique) ou d’un pseudomot et leur prononciation vont impliquer l’activation, par un seul mécanisme, de trois types de codes : orthographique, phonologique (automatique et précoce) et sémantique (non implémenté10). Chacun de ces codes correspond à des codes d’activations distribuées d’unités cachées, interconnectées et opérant en parallèle. Selon le PDP, les représentations orthographiques, phonologiques et sémantiques ne sont pas stockées dans des lexiques différenciés, mais ce sont les codes d’activations de ces représentations qui vont permettre la lecture des mots par une procédure d’apprentissage implicite autocorrectrice (i.e., rétropropagation de l’erreur) des règles CGP, phonotactiques et statistiques, sans l’apprentissage de règles préalables explicites.

Cependant, les partisans des modèles à double voie (e.g., Coltheart et al., 1993) ont vivement critiqué les résultats à cause de performances en lecture de pseudomots faibles, plus faibles qu’avec des humains, mais aussi parce que l’apprentissage est basé sur des unités cachées demeure opaque et enfin, parce que contrairement au modèle, la version implémentée n’établit pas les connexions nécessaires pour que les représentations phonologiques influencent les représentations orthographiques (Ferrand & Grainger, 2003 ; Stone, Vanhoy & Van Orden, 1997). Plaut et al. (1996) ont mis au point une version améliorée du PDP de Seidenberg et McClelland (1989), le réseau GRAIN (i.e., Graded Random Adaptative Interactive Nonlinear). Plaut et al. (1996) ont abandonné les représentations distribuées pour les remplacer par des représentations symboliques et localisées selon un codage en slot représentant les unités infralexicales attaque, pic vocalique et rime. Toujours basé sur une procédure d’auto-apprentissage, mais avec une rétro-propagation de l’erreur notamment graduelle et adaptative, les performances dès lors obtenues en lecture de pseudomots sont accrues, mais ces modifications rompent avec « la philosophie même des modèles de traitement parallèle distribué qui, par définition, utilisent des représentations distribuées et non pas locales » (Ferrand, 2001, p. 194).